Метрика оцінювання МП METEOR

METEOR (Metric for Evaluation of Translation with Explicit ORdering) — метрика для оцінювання якості машинного перекладу. Метрика базується на використанні n-gram та орієнтована на використання статистичної та точної оцінки вихідного тексту. На відміну від метрики BLUE, дана метрика використовує функції співставлення синонімів разом із точною відповідністю слів. Метрика була розроблена, щоб вирішити проблеми, які були знайдені в більш популярній метриці BLUE, а також відтворити хорошу кореляцію з оцінкою експертів на рівні словосполучень або речень.

В результаті запуску метрики на рівні словосполучень кореляція з людським рішенням становила 0.964 тоді як метрика BLUE становила 0.817 на тому ж наборі вхідних даних. На рівні речень максимальна кореляція з оцінкою експертів була 0.403.[1]

Як і в метриці BLUE, основна одиниця для оцінки — речення, алгоритм спочатку проводить вирівнювання тексту між двома реченням, рядком еталонного перекладу та рядком вхідного тексту для оцінювання (див. рисунки а та б). Дана метрика використовує декілька етапів встановлення відповідності між словами машинного перекладу й еталонного перекладу для зіставлення двох рядків:

1. Точне встановлення відповідності — визначаються рядки, що є ідентичними в еталонному і машинному перекладі.

2. Встановлення відповідності основ — проводиться стемінг (виділення основи слова) і визначаються слова з однаковим коренем в еталонному і машинному перекладі.

3. Встановлення відповідності синонімів — визначаються слова, що є синонімами відповідно до WordNet.

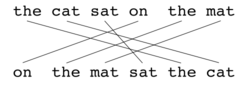

Вирівнювання — є множиною відповідностей між n-gram-ами. На відповідності накладається наступне обмеження: кожен n-gram в реченні-кандидаті повинен відповідати одному або жодному n-gram-у в еталонному реченні. Якщо є два вирівнювання з тіє самою кількістю збігів, то вибирається те, яке має найменшу кількість перетинів для збігів. В такому випадку буде вибрано варіант (а). Етапи порівняння з еталонними перекладами виконуються послідовно і на кожному з них до множини відповідностей додаються тільки ті n-gram-и, які не мали відповідності на попередніх етапах. Я тільки буде пройдено останній етап, остаточний n-gram P обчислюється за наступною формулою:[2]

| Приклад пар слів, які будуть співставлені разом | |||

| Етап порівняння | Кандидат | Еталонний переклад | Співпвдіння |

|---|---|---|---|

| Точний збіг | good | good | Yes |

| Стемінг | goods | good | Yes |

| Синонім | well | good | Yes |

Де m — кількість n-gram в машинному перекладі, які також були знайдені в еталонному перекладі, а wt — кількість n-gram в машинному перекладі. N-gram R (загальний n-gram для еталонних перекладів) обчислюється за наступною формулою:

Де wr — кількість n-gram в еталонному перекладі. Для визначення гармонічності перекладу (harmonic mean) застосовується наступна формула.

Дана формула використовується тільки для порівняння поодиноких слів, які збіглися в еталонному та машинному перекладі. Для того, щоб враховувати ще й словосполучення які збігаються, використовується так званий штраф p. Для цього n-gram об'єднують в декілька можливих груп. Штраф обчислюється за наступною формулою:

Де c — кількість груп n-gram, а — кількість n-gram, які об'єднали у групи Тоді фінальний показник якості обчислюється за наступною формулою:

| Еталонний переклад: | the | cat | sat | on | the | mat |

| Машинний переклад: | on | the | mat | sat | the | cat |

Score: 0.5000 = Fmean: 1.0000 * (1 - Penalty: 0.5000) Fmean: 1.0000 = 10 * Precision: 1.0000 * Recall: 1.0000 / (Recall: 1.0000 + 9 * Precision: 1.0000) Penalty: 0.5000 = 0.5 * (Fragmentation: 1.0000 ^3) Fragmentation: 1.0000 = Chunks: 6.0000 / Matches: 6.0000

| Еталонний переклад: | the | cat | sat | on | the | mat |

| Машинний переклад: | the | cat | sat | on | the | mat |

Score: 0.9977 = Fmean: 1.0000 * (1 - Penalty: 0.0023) Fmean: 1.0000 = 10 * Precision: 1.0000 * Recall: 1.0000 / (Recall: 1.0000 + 9 * Precision: 1.0000) Penalty: 0.0023 = 0.5 * (Fragmentation: 0.1667 ^3) Fragmentation: 0.1667 = Chunks: 1.0000 / Matches: 6.0000

| Еталонний переклад: | the | cat | sat | on | the | mat | |

| Машинний переклад: | the | cat | was | sat | on | the | mat |

Score: 0.9654 = Fmean: 0.9836 * (1 - Penalty: 0.0185) Fmean: 0.9836 = 10 * Precision: 0.8571 * Recall: 1.0000 / (Recall: 1.0000 + 9 * Precision: 0.8571) Penalty: 0.0185 = 0.5 * (Fragmentation: 0.3333 ^3) Fragmentation: 0.3333 = Chunks: 2.0000 / Matches: 6.0000

- ↑ Banerjee, S. and Lavie, A. (2005)

- Banerjee, S. and Lavie, A. (2005) «METEOR: An Automatic Metric for MT Evaluation with Improved Correlation with Human Judgments» in Proceedings of Workshop on Intrinsic and Extrinsic Evaluation Measures for MT and/or Summarization at the 43rd Annual Meeting of the Association of Computational Linguistics (ACL-2005), Ann Arbor, Michigan, June 2005

- Lavie, A., Sagae, K. and Jayaraman, S. (2004) «The Significance of Recall in Automatic Metrics for MT Evaluation» in Proceedings of AMTA 2004, Washington DC. September 2004

- The METEOR Automatic Machine Translation Evaluation System (including link for download)

Цю статтю треба вікіфікувати для відповідності стандартам якості Вікіпедії. |